Bayangkan begini: otak kita ini kayak prosesor komputer, tapi kerjanya nggak cuma buat mikirin cicilan atau bales chat mantan. Sekarang, otak ini juga harus pintar ngatur resource biar bisa nge-game (baca: training AI) sambil streaming film (baca: inference AI) tanpa bikin kantong jebol karena tagihan listrik melonjak. Itulah tantangan yang dijawab oleh Fulcrum, sebuah sistem baru yang bikin deep learning di perangkat edge jadi lebih efisien. Jadi, mari kita bedah, kenapa ini penting dan gimana caranya kerja!

Optimasi: Jurus Ampuh Hemat Baterai ala AI

Dalam dunia AI yang makin canggih, kita makin sering lihat aplikasi AI canggih hadir di smartphone atau perangkat IoT lainnya. Dari asisten virtual sampai fitur kamera pintar, semua itu butuh deep learning. Tapi, masalahnya, perangkat edge ini punya sumber daya terbatas. Baterai cepat habis, performa lambat, dan data pribadi rentan bocor. Nah, di sinilah pentingnya optimasi. Ibaratnya, kita nggak cuma mau mobil yang kencang, tapi juga irit bahan bakar dan nggak bikin malu pas diparkir di depan mal.

Optimasi ini melibatkan banyak hal, mulai dari pengaturan frekuensi CPU dan GPU, jumlah core yang dipakai, sampai kecepatan memori. Tujuannya sederhana: dapatkan performa maksimal dengan konsumsi daya minimal. Ini bukan cuma soal hemat listrik, tapi juga soal menjaga data tetap aman di perangkat kita, nggak dikirim ke server entah di mana.

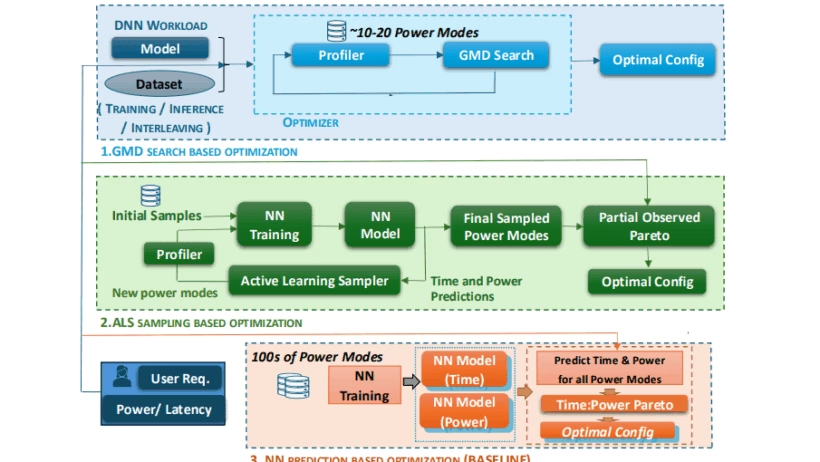

Para ilmuwan nggak tinggal diam melihat masalah ini. Mereka menciptakan algoritma bernama Gradient-based Multi-Dimensional Search (GMD) untuk training dan Active Learning-based Sampling (ALS) untuk inference. Kedua algoritma ini kayak duo detektif yang mencari konfigurasi terbaik buat perangkat edge kita.

GMD dan ALS: Duo Detektif Pemburu Konfigurasi Terbaik

GMD, si detektif pertama, bekerja dengan cara mencoba berbagai konfigurasi sumber daya secara iteratif. Bayangkan dia kayak gamer yang lagi nyari setting grafis paling pas buat PC-nya. Dia mulai dengan konfigurasi awal, lalu perlahan mengubah pengaturan satu per satu, sambil mengukur performa dan konsumsi daya. Tujuannya? Menemukan titik manis di mana performa optimal tercapai tanpa bikin perangkat panas kayak kompor.

Sementara itu, ALS, si detektif kedua, lebih cerdas lagi. Dia menggunakan machine learning untuk memprediksi performa dan konsumsi daya dari berbagai konfigurasi. Ibaratnya, dia punya cenayang yang bisa meramal masa depan. Dengan begitu, dia bisa memilih konfigurasi yang paling menjanjikan tanpa harus mencoba semuanya satu per satu. Lebih efisien, kan?

Time-Slicing: Juggling ala AI di Perangkat Edge

Salah satu tantangan terbesar dalam deep learning di perangkat edge adalah menjalankan training dan inference secara bersamaan. Perangkat seperti Nvidia Jetson seringkali nggak punya dukungan bawaan untuk pemanfaatan GPU secara konkuren. Selain itu, ada banyak sekali mode daya yang berbeda, yang bikin optimasi jadi makin rumit.

Untuk mengatasi masalah ini, para peneliti mengembangkan pendekatan time-slicing yang cerdas. Idenya adalah membagi waktu pemrosesan menjadi potongan-potongan kecil (minibatch) dan menjalankan training dan inference secara bergantian. Ini kayak juggling bola, di mana kita harus menjaga semua bola tetap di udara tanpa menjatuhkan satu pun.

Fulcrum: Dalang di Balik Layar Optimasi

Semua strategi optimasi ini diintegrasikan ke dalam sebuah scheduler bernama Fulcrum. Fulcrum inilah yang bertugas mengatur lalu lintas data dan sumber daya di perangkat edge. Dia memantau beban kerja, menyesuaikan mode daya, dan mengatur ukuran minibatch secara dinamis. Tujuannya adalah memaksimalkan throughput (jumlah data yang diproses per satuan waktu) sambil tetap mematuhi batasan daya dan latensi.

Mengapa Profiling Itu Penting, Tapi Mahal?

Salah satu tujuan utama dari penelitian ini adalah meminimalkan kebutuhan akan profiling yang mahal dan memakan waktu. Profiling adalah proses mengukur performa dan konsumsi daya dari berbagai konfigurasi perangkat. Ini penting untuk memahami karakteristik perangkat dan menemukan konfigurasi yang optimal. Namun, proses ini bisa sangat lama dan mahal, terutama jika kita harus mencoba ribuan konfigurasi yang berbeda.

GMD dan ALS dirancang untuk meminimalkan kebutuhan akan profiling. GMD, misalnya, hanya melakukan profiling pada 10-15 mode daya untuk mencapai solusi dalam waktu 5-10 menit. Sementara itu, ALS melakukan profiling pada 50-150 mode daya, yang memakan waktu sekitar 1.5 jam. Tapi, ALS punya potensi untuk digeneralisasikan ke konfigurasi masalah lain dengan daya, latensi, dan tingkat kedatangan yang bervariasi.

GMD: Si Cepat yang Efisien

GMD bekerja dalam ruang solusi empat dimensi yang ditentukan oleh frekuensi CPU/GPU/memori dan jumlah core CPU. Metode ini mulai dengan profiling mode daya awal dan menggunakan pengetahuan ini untuk memangkas ruang pencarian. Secara iteratif, GMD memilih dan melakukan profiling pada mode daya berikutnya.

Para peneliti menunjukkan bahwa penggunaan pengetahuan domain oleh GMD untuk memandu arah pencarian menghindari pemangkasan kandidat yang layak secara tidak benar. Mereka menyelidiki hubungan antara frekuensi GPU dan waktu pelatihan, mengungkapkan korelasi non-linear di mana waktu pelatihan awalnya menurun tajam dengan meningkatnya frekuensi sebelum mencapai dataran tinggi, sementara konsumsi daya terus meningkat. Wawasan ini menginformasikan pengembangan GMD, memungkinkannya untuk secara efisien menavigasi interaksi kompleks antara kinerja dan konsumsi daya.

ALS: Si Cerdas yang Belajar dari Pengalaman

ALS mengambil pendekatan yang berbeda. Alih-alih hanya mencoba-coba konfigurasi secara acak, ALS menggunakan active learning untuk memilih konfigurasi yang paling informatif untuk diprofilkan. Ini kayak belajar dari pengalaman. Semakin banyak konfigurasi yang diuji, semakin pintar ALS dalam memprediksi performa dan konsumsi daya dari konfigurasi lain.

ALS membangun model jaringan saraf awal menggunakan sejumlah kecil mode daya yang dipilih secara acak. Kemudian, secara iteratif, ALS memilih mode tambahan berdasarkan potensi mereka untuk mendiversifikasi nilai daya dan waktu yang diamati. Sistem yang dihasilkan membangun partial Pareto front, kurva yang mewakili trade-off antara performa dan konsumsi daya, langsung dari data yang diprofilkan, menghilangkan kesalahan prediksi dalam proses optimasi.

Hasilnya? Performa Mantap, Daya Irit

Eksperimen menunjukkan bahwa baik ALS maupun GMD mengungguli metode baseline yang lebih sederhana dan lebih kompleks. Mereka berhasil dalam 97% kasus dan memberikan solusi dalam 0.5% dari throughput optimal secara teoritis. Singkatnya, Fulcrum mampu memaksimalkan performa perangkat edge kita tanpa bikin baterai cepat habis.

Masa Depan AI di Ujung Jari Kita

Dengan adanya sistem seperti Fulcrum, masa depan AI di perangkat edge terlihat semakin cerah. Kita bisa menikmati aplikasi AI yang canggih tanpa harus khawatir soal daya tahan baterai atau privasi data. Dari mobil otonom sampai perawatan kesehatan personal, potensi aplikasi AI di perangkat edge sangatlah besar. Tentunya dengan catatan, kita tetap harus bijak dalam menggunakan teknologi ini, nggak cuma buat pamer atau cari sensasi belaka.

Jadi, tunggu apa lagi? Mari kita sambut era baru AI yang lebih efisien, lebih aman, dan lebih dekat dengan kehidupan kita sehari-hari. Siapa tahu, suatu saat nanti, AI bisa bantu kita masak nasi goreng yang enak tanpa gosong atau bahkan cari jodoh yang nggak bikin sakit kepala. Asyik, kan?