Siap-siap mind blown, karena ada penelitian baru yang bikin kita bertanya-tanya: Apakah kecerdasan buatan (AI) beneran mikir kayak manusia, atau cuma jago nyocokin pola? Penasaran kan?

AI Bisa Mikir? Atau Cuma Jago Nge-Cheat?

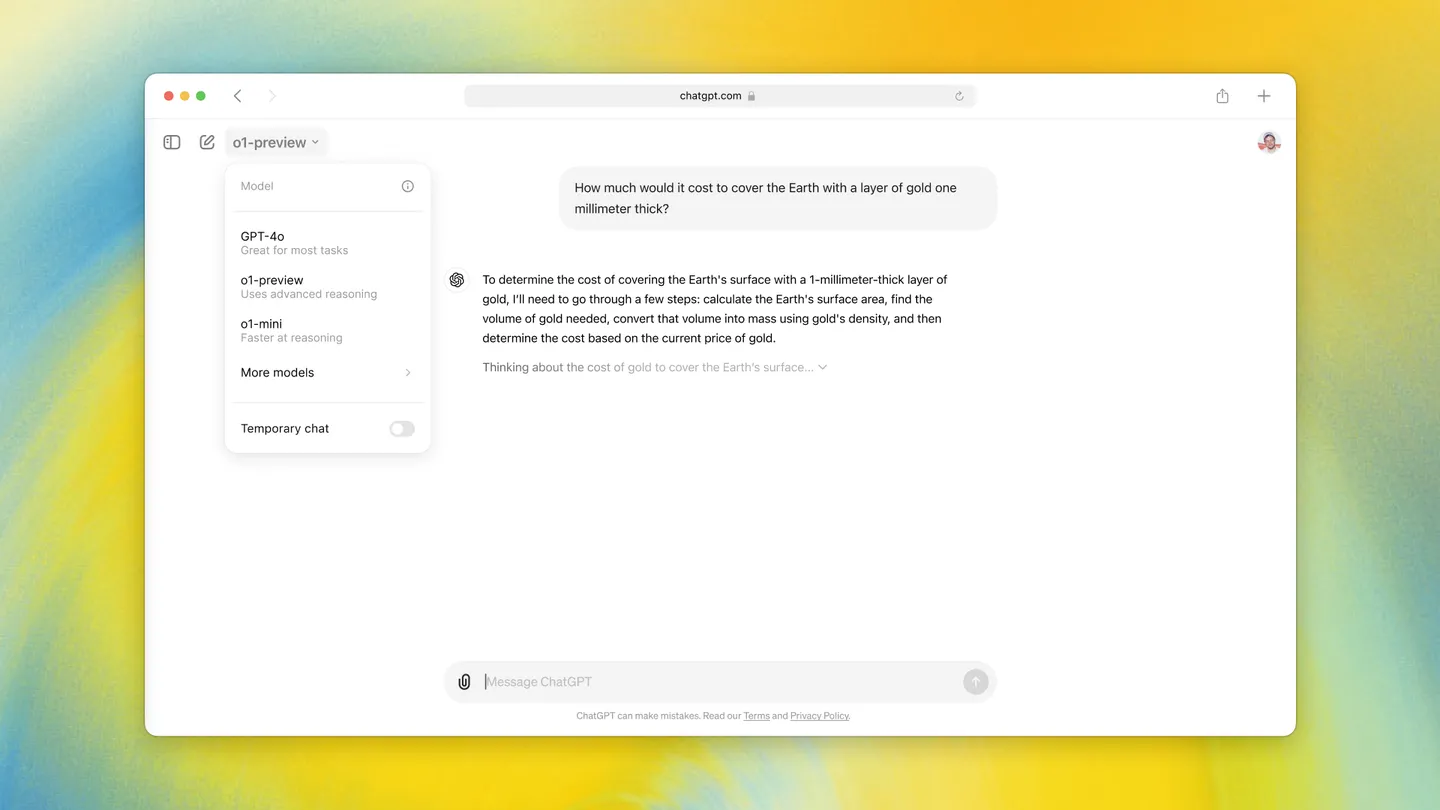

Banyak yang bilang, dengan teknik Chain-of-Thought (CoT) prompting, AI jadi makin pinter. CoT ini kayak ngajarin AI buat mecahin masalah kompleks jadi langkah-langkah logis. Hasilnya? AI makin jago nalar, matematika, dan mecahin teka-teki. Bahkan, ada yang berpendapat, AI udah mulai punya kemampuan nalar kayak manusia, dan bakal makin canggih seiring perkembangan teknologi. Tapi, tunggu dulu…

Tim peneliti dari Arizona State University (ASU) punya pendapat yang agak berbeda. Mereka bilang, kemampuan nalar CoT itu cuma “ilusi yang rapuh”. Artinya, AI cuma jago kalau data yang diuji mirip sama data yang dipelajari. Begitu ada perubahan sedikit aja, langsung zonk.

Data Adalah Segalanya (atau Bukan?)

Buat ngebuktiin teorinya, tim ASU bikin lingkungan terkontrol bernama DataAlchemy. Di situ, mereka ngelatih AI dari nol dan nguji kemampuannya nalar berdasarkan tiga faktor: jenis tugas, panjang tugas, dan format input. Tugasnya sendiri sederhana banget, yaitu transformasi huruf siklik. Bayangin aja, huruf A digeser jadi N, atau kata APPLE jadi EAPPL. Simpel, kan?

Setelah AI-nya jago, mereka kasih soal yang sedikit beda. Misalnya, AI dilatih cuma dengan satu aturan, tapi diuji dengan aturan lain. Atau, dilatih dengan kata empat huruf, tapi diuji dengan kata tiga atau lima huruf.

Hasilnya? Ngenes. AI langsung gagal total. Mereka cuma ngulang pola yang udah dipelajari, bukannya mikir buat mecahin masalah. Performanya langsung drop begitu panjang input atau jumlah langkah penalaran berubah. Bahkan, perubahan kecil di format input, kayak nambahin “noise tokens” sebelum huruf aslinya, udah cukup buat ngerusak kemampuan nalar CoT AI. Ini bukti kuat bahwa AI mungkin lebih jago meniru daripada benar-benar berpikir.

“Intinya, LLM bukanlah reasoner yang punya prinsip, melainkan simulator canggih teks yang mirip penalaran,” tulis para peneliti. Waduh, pedes banget nih!

Jangan Ketipu Sama “Fluent Nonsense”

Tim ASU ngingetin, jangan sampai kita salah paham dan nganggep output CoT sebagai penalaran yang beneran, apalagi buat aplikasi yang penting banget. AI bisa ngasih jawaban yang meyakinkan, tapi sebenernya ngaco secara logika. Istilahnya, “fluent nonsense”. Ini bahaya banget!

Para peneliti ngasih contoh konkret: waktu ditanya apakah tahun berdirinya Amerika Serikat (1776) adalah tahun kabisat, model Google Gemini awalnya jawab bener: “1776 bisa dibagi 4, tapi bukan tahun abad, jadi ini tahun kabisat.” Tapi, di kalimat berikutnya, modelnya malah kontradiksi dan nyimpulin kalau tahun berdirinya AS itu bukan tahun kabisat. Gimana tuh? Jawaban kedengeran pinter, tapi nggak logis.

Pertanyaannya, apakah kecerdasan buatan memang bisa mikir, atau cuma niru-niru doang?

LLM dan Ilusi Berpikir

Hasil penelitian ASU ini senada sama riset lain yang mempertanyakan kemampuan nalar AI. Salah satunya, penelitian dari Apple berjudul “The Illusion of Thinking”. Mereka berpendapat, AI cuma ngandelin pengenalan pola permukaan, bukannya perencanaan simbolik atau pemahaman struktural yang beneran. Tapi, ada juga yang bilang, pandangan ini terlalu sederhana. Soalnya, AI kadang bisa mecahin masalah dengan bikin kode atau pake alat eksternal.

Penelitian dari Tsinghua University dan Shanghai Jiao Tong University nemuin bahwa reinforcement learning dengan hadiah yang bisa diverifikasi (RLVR) emang ningkatin akurasi percobaan pertama, tapi nggak ngebantu AI ngembangin strategi pemecahan masalah baru. Malah, RLVR cenderung nguatirin pola yang udah dikenal dan ngebatasin diversitas. Singkatnya, RLVR bikin AI makin jago di zona nyaman, tapi nggak berani keluar dari zona nyaman.

Underthinking: AI Kurang Mikir?

Ada juga penelitian dari New York University yang nguji kemampuan AI buat ngikutin aturan tata bahasa formal dalam setting zero-shot. Hasilnya? Begitu masalahnya makin kompleks, bahkan model penalaran khusus pun ikutan zonk. Mereka seringkali nunjukkin “underthinking“, yaitu pake langkah-langkah perantara yang lebih sedikit waktu ngadepin masalah yang lebih susah. Menurut para peneliti, buat ngadepin tantangan ini, AI butuh sumber daya komputasi yang jauh lebih besar atau strategi solusi yang lebih efisien.

Jadi, Apa Kesimpulannya?

Intinya, jangan terlalu cepet percaya sama kemampuan “nalar” AI. Walaupun keliatannya pinter, mereka mungkin cuma jago nyocokin pola dan ngeluarin jawaban yang kedengeran logis, tapi sebenernya ngaco. Kita tetep harus skeptis dan kritis waktu ngadepin AI, apalagi buat hal-hal yang penting banget. Jangan sampai ketipu sama “fluent nonsense”!