Siap-siap, guys, karena kita akan membahas sesuatu yang mungkin lebih seru dari update TikTok terbaru! Bayangkan kamu punya "otak super" AI, tapi harus diajari trik baru. Nah, ada dua cara utama: fine-tuning dan in-context learning (ICL). Mana yang lebih jago bikin AI makin pinter?

Fine-Tuning vs. ICL: Pertarungan Metode Belajar AI

Fine-tuning itu ibarat melatih atlet untuk pertandingan spesifik. Kita ambil model AI yang sudah jagoan, lalu latih lagi dengan data yang lebih spesifik. Tujuannya? Mengubah parameter internal model agar bisa melakukan tugas tertentu dengan lebih baik. Sedangkan in-context learning (ICL) lebih mirip memberikan contekan saat ujian. Kita tidak mengubah "otak" AI-nya, tapi memberikan contoh langsung dalam pertanyaan. AI lalu menggunakan contoh ini untuk menjawab pertanyaan baru. Mana yang lebih efektif? Itulah yang sedang jadi perdebatan seru di kalangan developer AI.

Untuk menguji seberapa jagoan kedua metode ini, para peneliti menggunakan dataset sintetis yang rumit. Dataset itu berisi pengetahuan faktual dengan struktur yang kompleks, seperti silsilah keluarga fiksi atau hierarki konsep imajiner. Lebih serunya lagi, semua kata benda, sifat, dan kata kerja diganti dengan istilah ngaco. Jadi, model AI benar-benar harus belajar dari nol, tanpa bisa mengandalkan pengetahuan sebelumnya. Percayalah, lebih membingungkan dari tugas coding tengah malam!

Mereka menguji kemampuan generalisasi model dengan berbagai tantangan. Misalnya, pembalikan sederhana: Jika model diajari bahwa "femp lebih berbahaya daripada glon," bisakah ia menyimpulkan bahwa "glon kurang berbahaya daripada femp"? Atau silogisme sederhana: Jika model diberi tahu “Semua glon adalah yomp” dan “Semua troff adalah glon,” bisakah model menyimpulkan bahwa “Semua troff adalah yomp”? Bayangkan ini seperti ujian logika ala Sherlock Holmes, tapi untuk AI.

ICL Juaranya? Lebih Fleksibel dari Senam Lantai!

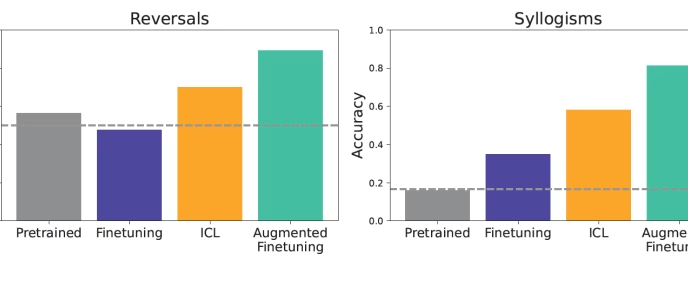

Hasilnya cukup mengejutkan. Dalam pengaturan data yang sesuai, ICL menghasilkan generalisasi yang lebih baik daripada fine-tuning standar. Model yang menggunakan ICL umumnya lebih baik dalam tugas-tugas seperti membalikkan hubungan atau membuat deduksi logis dari konteks yang diberikan. Model pre-trained tanpa fine-tuning atau ICL, ya… ambyar! Ini lho bukti bahwa data tesnya memang benar-benar baru dan menantang.

Namun, ada trade-off yang perlu dipertimbangkan. ICL memang tidak memerlukan fine-tuning (hemat biaya pelatihan), tetapi secara komputasi lebih mahal pada setiap penggunaan. Kita perlu memberikan konteks tambahan ke model, yang memakan waktu dan sumber daya. Jadi, ini seperti memilih antara biaya upgrade mobil atau biaya bensin harian.

Jurus Jitu: Mengawinkan Fine-Tuning dengan ICL (Augmented Fine-Tuning)

Nah, ini dia yang menarik! Para peneliti menawarkan solusi hybrid yang menggabungkan kekuatan kedua metode. Idenya sederhana: menambahkan inferensi in-context ke data fine-tuning. Jadi, kita menggunakan kemampuan ICL model AI untuk menghasilkan contoh yang lebih beragam dan kaya, lalu menambahkan contoh-contoh ini ke dataset yang digunakan untuk fine-tuning.

Ada dua strategi augmentasi data utama:

-

Strategi Lokal: Fokus pada informasi individual. Model AI diminta untuk menyusun ulang kalimat dari data pelatihan atau menarik inferensi langsung dari mereka, seperti menghasilkan pembalikan. Anggap saja seperti memberikan cheat sheet kecil untuk setiap soal.

- Strategi Global: Model AI diberi seluruh dataset pelatihan sebagai konteks, lalu diminta untuk menghasilkan inferensi dengan menghubungkan dokumen atau fakta tertentu dengan sisa informasi yang diberikan. Ini seperti meminta AI untuk membuat peta konsep dari semua materi pelajaran.

Hasilnya? Epic Win! Generalisasi Naik Tingkat!

Ketika model di-fine-tune pada dataset yang diperkaya ini, hasilnya luar biasa! Augmented fine-tuning secara signifikan meningkatkan generalisasi, mengungguli tidak hanya fine-tuning standar tetapi juga ICL biasa. Bayangkan efeknya: Kita bisa membangun model yang lebih kuat dan andal yang berkinerja lebih baik pada berbagai input dunia nyata, tanpa mengeluarkan biaya inferensi berkelanjutan yang terkait dengan prompt in-context yang besar.

Misalnya, jika salah satu dokumen perusahaan menyatakan “XYZ adalah alat internal untuk menganalisis data”, hasil penelitian menunjukkan bahwa ICL dan augmented fine-tuning akan lebih efektif dalam memungkinkan model menjawab pertanyaan terkait seperti “Alat internal apa untuk analisis data yang ada?” Ini adalah langkah maju yang menjanjikan bagi perusahaan!

Investasi Cerdas: Data yang Diperkaya, AI yang Lebih Mantap

Dengan berinvestasi dalam membuat dataset yang diperkaya ICL ini, developer dapat membangun model yang di-fine-tune yang menunjukkan kemampuan generalisasi yang lebih kuat. Memang benar, augmented fine-tuning akan membuat proses fine-tuning model lebih mahal, karena memerlukan langkah tambahan ICL untuk memperkaya data, diikuti dengan fine-tuning. Tapi, apakah biaya tambahan itu sepadan dengan peningkatan generalisasi? Tergantung pada kasus penggunaan spesifiknya. Namun secara komputasi, itu lebih murah daripada menerapkan ICL setiap kali model digunakan, jika diamortisasi selama banyak penggunaan model.

Penelitian lebih lanjut masih diperlukan, tetapi hasilnya menunjukkan bahwa developer mungkin ingin mempertimbangkan untuk menjelajahi augmented fine-tuning dalam kasus di mana mereka melihat kinerja yang tidak memadai dari fine-tuning alone. Intinya? Memahami cara terbaik untuk mengajari AI kita akan membuka potensi tak terbatas!