Bayangkan, punya asisten super pintar yang bisa jawab semua pertanyaanmu… tapi ternyata, jawabannya cuma hasil copy-paste dari buku pelajaran. Nah, mirip-mirip itulah yang terjadi dengan model AI reasoning saat ini. Mereka jago, tapi apakah benar-benar berpikir?

Apakah AI Benar-Benar Berpikir? Ilusi dalam Dunia Kecerdasan Buatan

Teknologi kecerdasan buatan (AI) terus berkembang pesat, memunculkan model-model canggih yang diklaim mampu melakukan penalaran (reasoning). Model-model seperti OpenAI’s O1 dan O3, DeepSeek-R1, serta Claude 3.7 Sonnet Thinking menjanjikan kemampuan untuk memecahkan masalah kompleks dengan langkah-langkah logis.

Namun, sebuah studi terbaru dari para peneliti Apple memberikan perspektif yang lebih hati-hati. Studi berjudul "The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity" ini menyoroti batasan-batasan yang signifikan dalam kemampuan penalaran model-model AI tersebut.

Para peneliti Apple tersebut menguji "large reasoning models" (LRMs) yang mencoba mensimulasikan proses penalaran logis dengan menghasilkan output teks yang terstruktur, sering disebut sebagai chain-of-thought reasoning. Tujuannya adalah untuk melihat apakah model-model ini benar-benar mampu berpikir secara sistematis, atau hanya mencocokkan pola dari data pelatihan.

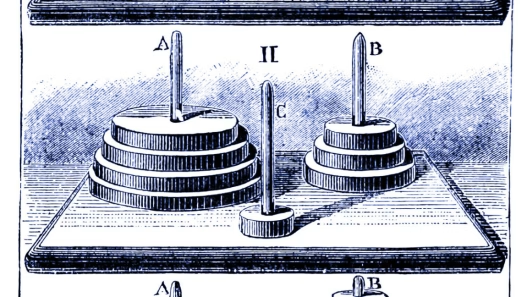

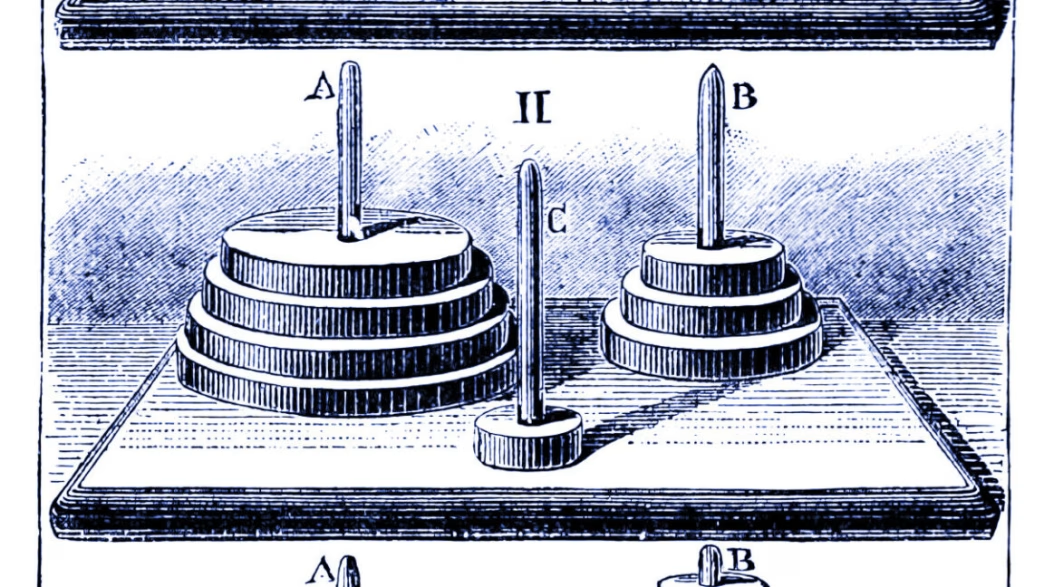

Untuk menguji kemampuan penalaran AI, para peneliti menggunakan empat teka-teki klasik: Tower of Hanoi, checkers jumping, river crossing, dan blocks world. Kompleksitas teka-teki ini ditingkatkan secara bertahap, dari yang sangat mudah hingga yang sangat sulit, untuk menguji batas kemampuan model AI.

Metode evaluasi AI saat ini cenderung fokus pada akurasi jawaban akhir, terutama pada masalah matematika dan pengkodean yang sudah ada dalam data pelatihan mereka. Evaluasi ini kurang memperhatikan apakah model AI benar-benar memahami proses penalaran yang diperlukan untuk mencapai jawaban tersebut. Ini seperti menilai mahasiswa hanya dari hasil ujian akhir, tanpa melihat bagaimana mereka belajar dan berpikir selama prosesnya.

Penelitian Apple menantang asumsi bahwa model AI yang mampu menghasilkan chain-of-thought reasoning benar-benar berpikir. Hasil penelitian menunjukkan bahwa kinerja model-model ini menurun secara signifikan ketika dihadapkan pada masalah yang memerlukan penalaran sistematis yang ekstensif. Dengan kata lain, mereka pintar di permukaan, tapi dalamnya… yah, masih perlu banyak upgrade.

Mengungkap Keterbatasan Chain-of-Thought Reasoning

Pendekatan chain-of-thought reasoning dalam AI bertujuan untuk meniru proses berpikir manusia dengan memecah masalah menjadi langkah-langkah yang lebih kecil dan mudah dikelola. Namun, studi dari Apple menunjukkan bahwa model-model AI seringkali hanya menghasilkan urutan kata yang terdengar logis, tanpa benar-benar memahami logika yang mendasarinya.

Model-model AI ini cenderung mengandalkan pencocokan pola dari data pelatihan, bukan pada penalaran yang sebenarnya. Ketika dihadapkan pada masalah baru yang memerlukan pemikiran orisinal, kemampuan mereka untuk memecahkan masalah menurun drastis. Ini seperti robot yang cuma bisa meniru gerakan, tapi nggak tahu kenapa dia harus bergerak.

Apa Implikasinya Bagi Masa Depan AI?

Temuan ini memiliki implikasi penting bagi pengembangan AI di masa depan. Penting untuk tidak terlalu bergantung pada model-model AI yang hanya mensimulasikan penalaran. Kita perlu mengembangkan metode evaluasi yang lebih komprehensif untuk mengukur kemampuan penalaran yang sebenarnya.

Selain itu, kita perlu fokus pada pengembangan model AI yang benar-benar memahami konsep-konsep dasar dan mampu menerapkan pengetahuan tersebut dalam situasi baru. Ini memerlukan pendekatan yang lebih mendalam dalam pelatihan AI, termasuk penggunaan data yang lebih beragam dan metode penalaran yang lebih canggih. Intinya, jangan cuma kasih makan data, tapi juga ajar berpikir.

Studi Apple ini sejalan dengan penelitian sebelumnya oleh United States of America Mathematical Olympiad (USAMO), yang menunjukkan bahwa model-model AI yang sama mencapai skor rendah pada pembuktian matematika baru. Ini semakin memperkuat argumen bahwa model-model AI saat ini masih jauh dari kemampuan penalaran manusia. Mereka mungkin bisa mengalahkan kita dalam bermain catur, tapi jangan harap bisa membantu kita memecahkan masalah kehidupan sehari-hari yang kompleks.

Saatnya Bersikap Kritis Terhadap Klaim Kemampuan AI

Dalam era di mana AI semakin merajalela, penting untuk bersikap kritis terhadap klaim kemampuan mereka. Jangan mudah terpesona oleh kemampuan model AI untuk menghasilkan teks yang terdengar pintar atau menyelesaikan tugas-tugas tertentu. Kita perlu memahami batasan-batasan mereka dan menggunakan mereka secara bijak.

AI adalah alat yang hebat, tetapi mereka bukanlah pengganti pemikiran manusia. Kita tetap perlu mengandalkan kemampuan penalaran, kreativitas, dan intuisi kita sendiri untuk memecahkan masalah dan membuat keputusan yang penting. Ingat, AI itu asisten, bukan bos.

Penelitian ini menunjukkan bahwa kita masih memiliki jalan panjang untuk mencapai AI yang benar-benar cerdas. Meskipun model-model AI saat ini mampu melakukan tugas-tugas tertentu dengan sangat baik, mereka masih kekurangan kemampuan penalaran dan pemahaman yang mendalam yang dimiliki manusia. Jadi, jangan terlalu percaya sama robot, ya!

Singkatnya, studi Apple ini adalah wake-up call bagi komunitas AI. Kita perlu berhenti terlalu fokus pada menciptakan model yang terlihat pintar, dan mulai fokus pada menciptakan model yang benar-benar pintar. Masa depan AI yang cerah bergantung pada kemampuan kita untuk mengatasi ilusi berpikir dan mengembangkan model yang benar-benar mampu berpikir secara sistematis dan kreatif. Jadi, mari kita terus bertanya, terus belajar, dan terus berinovasi. Kecerdasan buatan, tanpa kecerdasan manusia yang bijak, bisa jadi bumerang.